¿Están razonando los LLM?

Como los titulares de los medios ilustran, actualmente hay un debate encendido sobre si los Large Language Model (LLM) pre-entrenadas han alcanzado habilidades de razonamiento semejantes a las humanas, o si sus habilidades son en realidad «un espejismo».

El razonamiento es un aspecto central de la inteligencia humana, y las habilidades de razonamiento robustas e independientes del dominio han sido un objetivo clave para los sistemas de inteligencia artificial. Si bien los grandes modelos de lenguaje no se entrenan explícitamente para razonar, han exhibido comportamientos «emergentes» que a veces parecen razonamiento.

Pero ¿estos comportamientos están realmente impulsados por verdaderas habilidades de razonamiento abstracto, o por algún otro mecanismo menos robusto y generalizable, como memorizar sus datos de entrenamiento y luego buscar patrones en un problema dado que se asemejen a los encontrados en los datos de entrenamiento?

¿Por qué esto es importante? Si las habilidades de razonamiento generales y robustas han surgido en los LLMs, esto refuerza la afirmación de que tales sistemas son un paso importante hacia una inteligencia general confiable.

Por otro lado, si los LLMs dependen principalmente de la memorización y el emparejamiento de patrones en lugar de un razonamiento real, entonces no serán generalizables; no podremos confiar en que funcionen bien en tareas «fuera de distribución», aquellas que no son lo suficientemente similares a las tareas que han visto en los datos de entrenamiento.

¿Qué significa «Razonamiento»?

La palabra «razonamiento» es un término general que incluye habilidades de deducción, inducción, abducción, analogía, sentido común y otros métodos «racionales» o sistemáticos para resolver problemas. El razonamiento suele ser un proceso que implica componer múltiples pasos de inferencia. Generalmente, se cree que el razonamiento requiere abstracción; es decir, la capacidad de razonar no se limita a un ejemplo particular, sino que es más general. Si puedo razonar sobre la suma, no solo puedo resolver 23+37, sino cualquier problema de suma que se me presente. Si aprendo a sumar en base 10 y también aprendo sobre otras bases numéricas, mis habilidades de razonamiento me permiten aprender rápidamente a sumar en cualquier otra base.

El razonamiento «Cadena de Pensamiento» en los LLMs

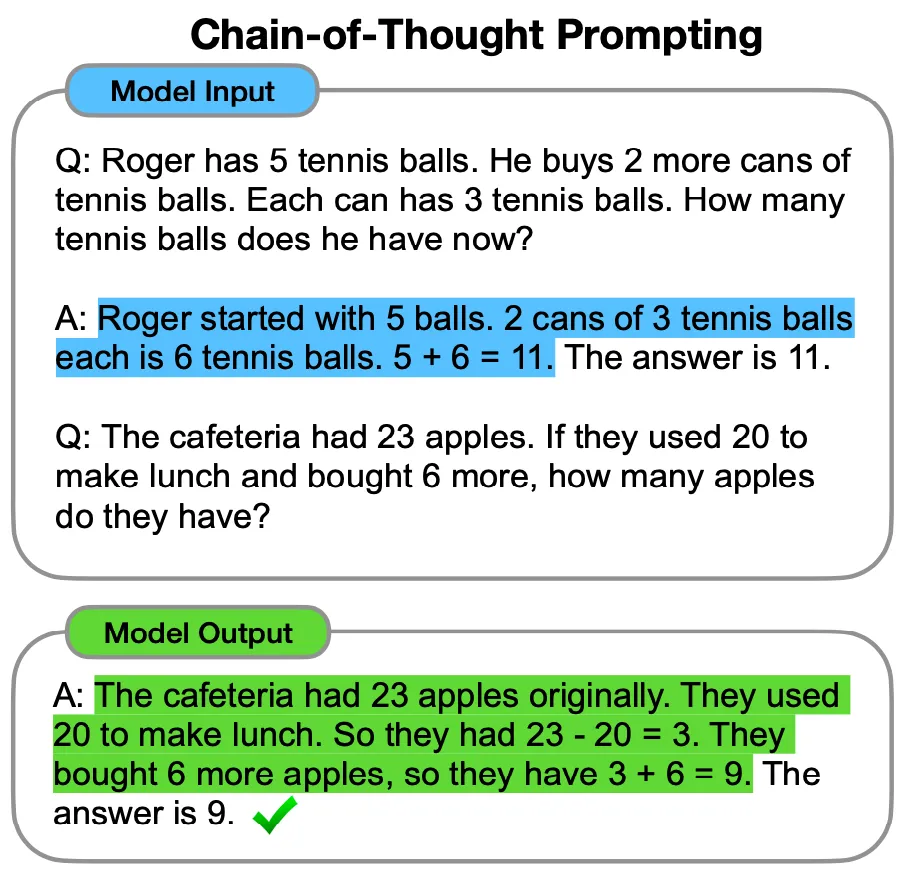

En los últimos años, ha habido una avalancha de trabajos que afirman que los LLMs tienen habilidades de razonamiento (Huang y Chang ofrecen una encuesta reciente). Uno de los trabajos más influyentes en este sentido (por Wei et al. de Google Research) propuso que las llamadas «Cadenas de Pensamiento» (CoT) provocan habilidades de razonamiento sofisticadas en estos modelos. Un prompt de CoT proporciona uno o más ejemplos de un problema y los pasos de razonamiento necesarios para resolverlo, y luego plantea un nuevo problema. El LLM luego generará texto que sigue un conjunto similar de pasos de razonamiento antes de ofrecer una respuesta. Este es un ejemplo del trabajo de Wei et al.:

Wei et al. probaron el método de CoT en conjuntos de datos con problemas matemáticos, problemas de razonamiento de sentido común y otros dominios. En muchos casos, el uso de CoT mejoró drásticamente el rendimiento de los LLMs en estos conjuntos de datos.

¿Son fieles los pasos de razonamiento generados bajo el Prompt de CoT?

Aunque los ejemplos anteriores de CoT y CoT sin ejemplos muestran al modelo de lenguaje generando texto que parece un razonamiento correcto y paso a paso sobre el problema dado, uno podría preguntarse si el texto generado por el modelo es «fiel»; es decir, ¿describe el proceso real de razonamiento que el LLM utiliza para resolver el problema? Los LLMs no se entrenan para generar texto que refleje con precisión sus propios procesos internos de «razonamiento»; se entrenan para generar solo texto que suena plausible en respuesta a un prompt. Entonces, ¿cuál es la conexión entre el texto generado y los procesos reales del LLM para llegar a una respuesta?

Esta pregunta ha sido abordada por diferentes investigadores. En un estudio, los investigadores encontraron que, en algunos casos, «las explicaciones de CoT pueden representar sistemáticamente de manera incorrecta la verdadera razón de la predicción de un modelo». Otro estudio encontró que, curiosamente, «a medida que los modelos se vuelven más grandes y capaces, producen un razonamiento menos fiel en la mayoría de las tareas que estudiamos».

Si los LLMs no están razonando, ¿Qué están haciendo?

Si resulta que los LLMs en realidad no están razonando para resolver los problemas que se les presentan, ¿cómo podrían estar resolviéndolos? Varios investigadores han demostrado que los LLMs son mucho mejores para resolver problemas que involucran términos o conceptos que aparecen con más frecuencia en sus datos de entrenamiento, lo que lleva a la hipótesis de que los LLMs no realizan un razonamiento abstracto sólido para resolver problemas, sino que resuelven problemas (al menos en parte) identificando patrones en sus datos de entrenamiento que coinciden, se asemejan o están relacionados de alguna otra manera con el texto de los prompts que se les dan.

Por ejemplo, un estudio realizado por Razeghi et al. mostró que algunos LLMs basados en GPT (preentrenados en un corpus conocido) eran mucho mejores para resolver problemas de aritmética que involucraban números que aparecían con frecuencia en el corpus de preentrenamiento que aquellos que aparecían con menos frecuencia.

Estos modelos parecen carecer de una habilidad general para la aritmética y en su lugar confían en una especie de «memorización», emparejando patrones de texto que han visto en el preentrenamiento. Los autores de ese estudio señalan que, a la luz de tales resultados, «cualquier evaluación del razonamiento que no tenga en cuenta los datos de preentrenamiento es difícil de interpretar y que debemos volver a evaluar los modelos de lenguaje con respecto a sus datos de preentrenamiento antes de sacar conclusiones sobre las capacidades de generalización de los modelos más allá de los datos de preentrenamiento».

¿Qué significa esto para el futuro de la inteligencia artificial?

Un apasionante trabajo de Wu et al. exploró la hipótesis de la «memorización» a través de lo que llamaron «tareas contrafactuales». La idea es tomar una tarea de razonamiento en la que un LLM se desempeña bien y crear una variante («versión contrafactual») de esa tarea que requiere la misma capacidad de razonamiento abstracto pero que probablemente haya aparecido con menos frecuencia en los datos de entrenamiento del LLM.

En resumen, la pregunta sobre si los LLMs están razonando o memorizando sigue sin respuesta definitiva. Lo que es claro es que los LLMs muestran un grado variable de razonamiento y memorización, y esta dicotomía tiene implicaciones significativas para su aplicabilidad en el mundo real. Como resultado, la evaluación de las habilidades de razonamiento generales de los LLMs se convierte en una tarea compleja y desafiante.

Fuente: AI: A Guide for Thinking Humans.